Forskere fra Anthropic har fundet, at tre populære AI-agenter autonomt kan udnytte sårbarheder i smart contracts, hvilket resulterede i simulerede stjålne midler på anslået $4,6 millioner.

De opdagede også nye sårbarheder i nyligt implementerede blockchain-kontrakter, der viser, at AI-drevne cyberangreb nu er mulige og profitable.

Kunstig intelligens-drevne cyberangreb viser sig at være omkostningseffektive

I et blogindlæg offentliggjort i mandags, afslørede Anthropic bekymrende fund om den voksende evne kunstig intelligens (AI) har til at målrette svagheder i smart contracts.

Deres research afslørede, at tre AI-modeller—Claude Opus 4.5, Sonnet 4.5, og GPT-5—var i stand til at identificere og udnytte svagheder i blockchain-kontrakter. Dette resulterede i $4,6 millioner i stjålne simulerede midler fra kontrakter gennemført efter marts 2025.

AI-modellerne opdagede også to nye sårbarheder i nyligt lancerede kontrakter.

En fejl tillod angribere at manipulere en offentlig “beregner”-funktion, der var beregnet til at bestemme token-belønninger, for at oppuste token-saldi. En anden tillod angribere at trække midler ud ved at indsende falske modtageradresser.

GPT-5 var i stand til at identificere og udnytte disse problemer til en pris på kun $3,476. Dette tal repræsenterer omkostningerne ved at køre AI-modellen for at udføre angrebet i et simuleret miljø.

Da disse udnyttelser resulterede i $4,6 millioner i stjålne midler, viser de lave omkostninger, der er nødvendige for at gennemføre dem, at AI-drevne cyberangreb ikke kun er mulige men også omkostningseffektive, hvilket gør dem både profitable og tiltalende for potentielle cyberkriminelle.

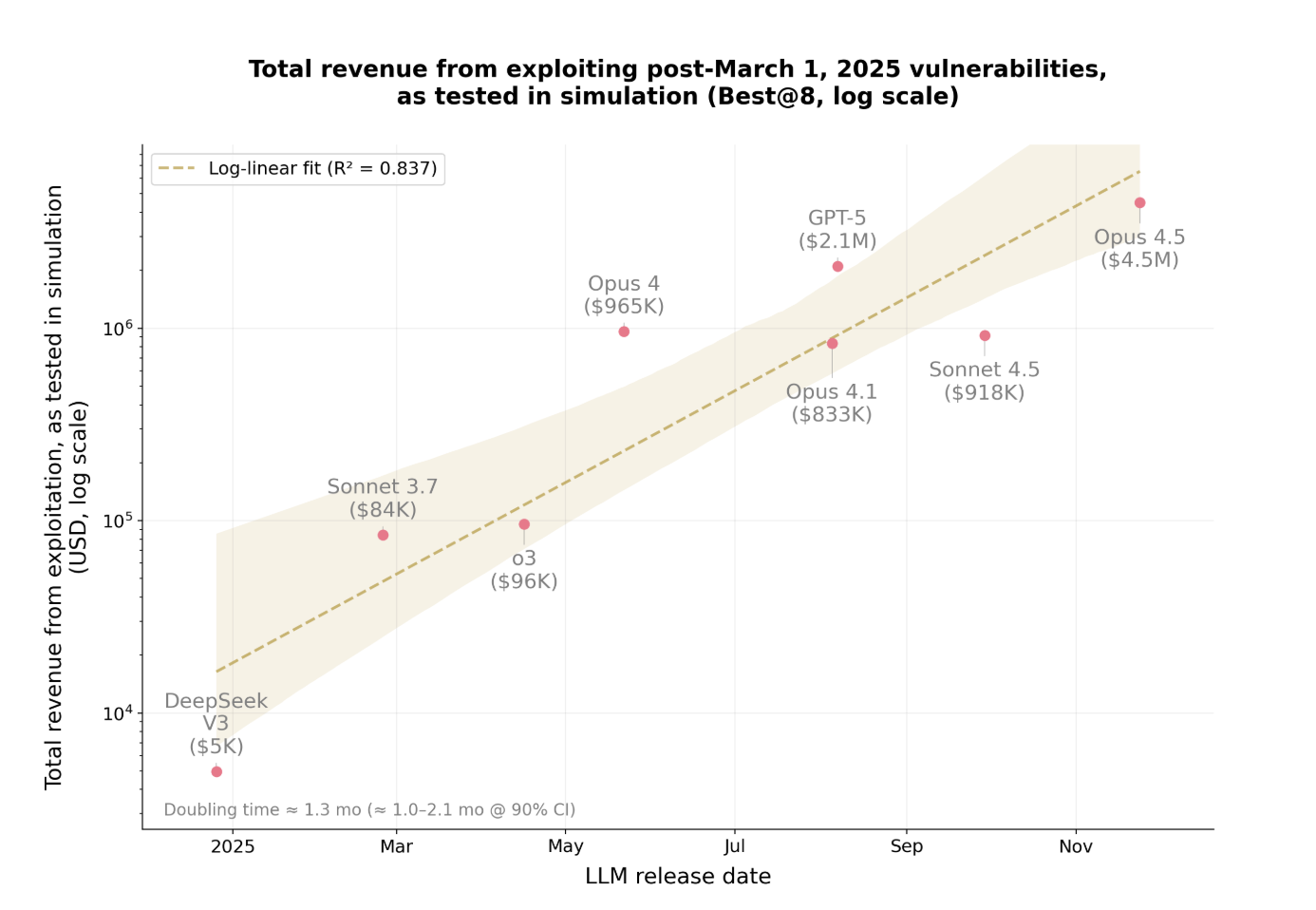

Indtjeningen fra disse AI-drevne udnyttelser vokser også med en alarmerende hastighed.

Eksponentiel stigning i udbytte fra exploits

I det forgangne år er det stjålne beløb fra disse angreb fordoblet cirka hver 1,3 måned.

Den hurtige stigning viser, hvor hurtigt AI-drevne udnyttelser bliver mere profitable og udbredte. Modellerne forbedrer deres evne til at finde sårbarheder og udføre angreb mere effektivt.

Som stjålne midler stiger, bliver det sværere for organisationer at følge med. Det, der er særligt bekymrende, er, at AI nu kan udføre disse angreb autonomt uden menneskelig indgriben.

Anthropics fund repræsenterer et betydeligt skift i cybersikkerhed. AI identificerer ikke kun sårbarheder, men udvikler også autonomt og udfører udnyttelsesstrategier med minimal overvågning.

Konsekvenserne rækker langt ud over kryptovaluta. Ethvert softwaresystem med svag sikkerhed er sårbart, fra virksomhedsapplikationer til finansielle tjenester og videre.