Diskussionen om OpenAI’s anden generation af DALL-E 2-systemet er fortsat polariserende, selv flere måneder efter lanceringen. Nogle kalder det en banebrydende innovation, der kan omdefinere kunsten. Imens ser modstanderne det som det første glimt af, hvordan AI-billedgeneratorer kan betyde undergang for kreative industrier.

Uanset hvad åbner DALL-E 2 op for nye muligheder (og udfordringer) for, hvordan vi skaber og forbruger kunst. Denne detaljerede anmeldelse af Dall-E 2 tager et dybt dyk ned i AI-billedgeneratoren. Hvordan er appen at bruge, og er der nogen store ulemper?

Hvad er DALL-E 2?

DALL-E 2 er en AI-billedgenerator. Den kan skabe billeder og kunstformer ud fra tekstbeskrivelser på et naturligt sprog. Det er med andre ord et system med kunstig intelligens, der genererer billeder ud fra tekst.

DALL-E 2 er efterfølgeren til OpenAI’s DALL-E-model, som blev lanceret i januar 2021. Navnet “DALL-E” er et sammensat ord af den berømte spanske kunstner Salvador Dalí og Wall-E, en populær animeret robotfigur fra Pixar.

I juli 2022 gik DALL-E 2 i beta og blev gjort tilgængelig for udvalgte brugere. OpenAI fjernede kravet om udvælgelse den 28. september 2022, hvilket gjorde det til en beta med åben adgang, som alle kunne bruge.

Ligesom den oprindelige DALL-E er DALL-E 2 også en generativ sprogmodel, der bruger tekstbeskeder til at skabe originale billeder. Det er en stor model med omkring 3,5 B parametre, men ikke helt så stor som sin forgænger, der brugte 12 B parametre. På trods af denne størrelsesforskel kan DALL-E 2 generere billeder med fire gange højere opløsning end sin første iteration – en imponerende opgradering. Den ser også ud til at gøre et markant bedre stykke arbejde med fotorealisme og billedtekstmatchning.

Sådan bruger du DALL-E 2

DALL-E 2 kan lyde futuristisk og muligvis skræmmende for nye brugere. Men det er imponerende ligetil at bruge. Denne DALL-E 2-anmeldelse vil ikke dykke for dybt ned i de praktiske detaljer. Men hvis du gerne vil lære at bruge værktøjet, kan du læse vores detaljerede guide til brug af DALL-E 2.

Her er en lille vejledning til dem, der gerne vil have et hurtigt overblik. Først skal du gå til DALL-E 2’s officielle hjemmeside og oprette en konto. Eller logge ind, hvis du allerede har en OpenAI-konto. Processen er hurtig, enkel og nem. Bemærk at du vil blive bedt om at angive din e-mail og dit telefonnummer til bekræftelse.

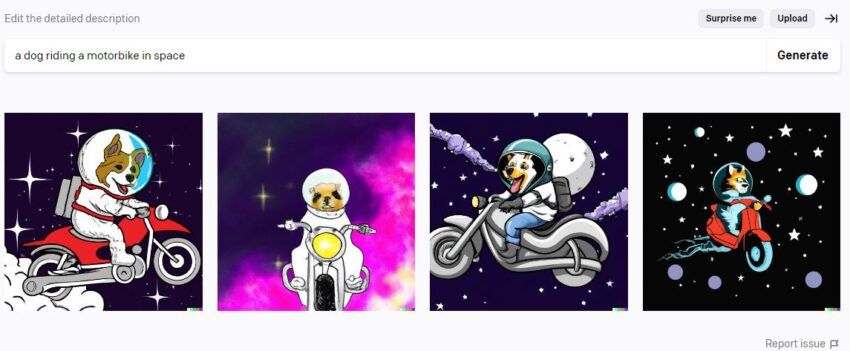

Når din konto er klar, skal du indsætte en beskrivende tekst på op til 400 tegn. AI-kunstgeneratoren klarer resten. Baseret på vores erfaringer med at teste programmet indtil videre, har vi fået originale og interessante resultater fra vores tekstprompter.

For eksempel skrev vi “ulveflok, der hyler ved fuldmåne” og fik nedenstående resultater (sammen med fire variationer pr. billede).

Og en tekstprompt med “3D model af en romersk soldat der hviler” gav disse billeder:

DALL-E 2: Under kølerhjelmen

DALL-E 2 har leveret en ny standard for kvaliteten af AI-billedgeneratorer. Den kan forstå tekstbeskrivelser meget bedre end noget, der kom før den. Dens overlegne forståelse af naturligt sprog resulterer i en bedre kontrol over stilarter, motiver, vinkler, baggrunde, steder og koncepter. Resultatet er billeder af højere kvalitet og en imponerende kunstform. Her er en beskåret version af, hvordan DALL-E fungerer.

Sådan fungerer DALL-E 2

For at forstå, hvordan AI-billedgeneratoren fungerer, skal du kende lidt til følgende begreber:

- CLIP: Står for Contrastive Language-Image Pre-training. Det er måske den mest kritiske byggesten i arkitekturen i DALL-E 2. Tilgangen er baseret på ideen om, at man kan bruge naturligt sprog til at lære computere, hvordan forskellige billeder forholder sig til hinanden. CLIP består af to neurale netværk – en tekst- og en billedkoder. Begge er trænet på store og forskelligartede samlinger af billed-tekst-par. Modellen analyserer disse billedtekstpar for at skabe vektorrepræsentationer kaldet tekst/billede-indlejringer. Med andre ord fungerer CLIP som en bro mellem tekst (input) og billede (output).

- Tidligere model: Den tager en billedtekst/CLIP-tekstindlejring og bygger videre på den for at generere CLIP-billedindlejringer.

- Decoder-diffusionsmodel (unCLIP): Den omvendte af den oprindelige CLIP-model genererer billeder ved hjælp af CLIP-billedindlejringer.

DALL-E 2 skaber et output ved at kombinere både prior- og unCLIP-modeller. Billedet nedenfor skitserer i grove træk den underliggende proces.

Som du måske kan se på billedet, skaber unCLIP-modellen en “mental” repræsentation af et billede. Derfra skaber den et originalt billede baseret på den generiske mentale repræsentation.

Den mentale repræsentation bevarer de centrale karakteristika og funktioner, der er semantisk konsistente. For eksempel dyr, objekter, farve, stil og baggrund. Men outputbilledet er nyt, fordi det varierer.

Bemærk, at det kun er et hurtigt resumé af, hvordan DALL-E 2 fungerer. De tekniske detaljer og matematikken i implementeringen er mere kompliceret (og uden for rammerne af denne Dall-E 2-anmeldelse).

Når det er sagt, har OpenAI udgivet en artikel: “Hierarchical Text-Conditional Image Generation with CLIP Latents” tidligere i år. Hvis du er interesseret i de tekniske specifikationer for DALL-E 2, er det et godt sted at starte din research.

Anmeldelse af DALL-E 2: Det gode og det dårlige

Ting, du kan gøre med DALL-E 2

Du kan generelt forvente flere output af høj kvalitet fra AI-kunstgeneratoren, så længe du bruger præcise og beskrivende tekstprompter. Det tager et par sekunder at lave en prompt af høj kvalitet, som det ville tage en maler eller digital kunstner timer, hvis ikke dage, at lave. Og du kan få adgang til alle disse visuelle ideer uden gebyr. Med et AI-genereret billede er der ingen lokationsgebyrer og ingen lønninger, der skal betales til kreative og modeller. Det er selvfølgelig både positivt og negativt, afhængigt af perspektivet.

DALL-E 2 bruger sin egen “forståelse” af emnet, stilen, farvepaletterne og den ønskede konceptuelle betydning, før den leverer et resultat.

Du kan få op til fire yderligere varianter af hvert billede. Hver variant afspejler originalens udseende, følelse og betydning, men med sin egen unikke stil.

Du kan også redigere billeder i DALL-E 2 – også uden nogen forudgående erfaring med billedredigering. I modsætning til visse førende billedredigeringsapps som Adobe Photoshop er det utroligt nemt at redigere med DALL-E. Du kan f.eks. male en astronaut, der går på Mars, og senere tilføje en hund til portrættet. Du skal blot skrive “sæt en hund bag astronauten”. På samme måde kan du også bede programmet om at ændre et billedes synsvinkel ved at zoome ind og ud, indtil du får det ønskede resultat.

Det er kun toppen af isbjerget, hvad angår DALL-E 2’s muligheder. Man kan få en bedre forståelse ved at bruge lidt tid på at bruge programmet og afprøve dets forskellige funktioner.

Systemet er designet til ikke at kunne generere indhold, der involverer pornografi, blod eller politiske elementer. Når det er sagt, har programmet sin del af begrænsninger og ulemper, som vi vil fremhæve i denne DALL-E 2-anmeldelse.

Begrænsningerne

En stor del af DALL-E 2’s outputkvalitet afhænger af kvaliteten af den tekstprompt du giver. Jo mere specifik du er, jo større er chancen for at få det ønskede output. Systemet har dog nogle indbyggede begrænsninger.

For eksempel er det endnu ikke særlig dygtigt til strukturalitet (selvom det ser ud til at blive bedre med tiden). Det betyder, at DALL-E 2 ofte ikke er i stand til at flette flere objekter eller objektegenskaber som form, retning og farve sammen på en meningsfuld måde.

Og det er ikke alt – programmet kan også være utilstrækkeligt selv ved (relativt) enkle opgaver. For eksempel skrev vi teksten “hundrede frøer klædt ud som romerske soldater, der marcherer gennem en ørken”. Resultatet var utilfredsstillende, selv efter at vi havde prøvet flere variationer af prompten.

Et andet eksempel er, da vi prøvede den ret enkle prompt: “en t-rex, der kører på ethjulet cykel foran Eifeltårnet.” Af en eller anden grund nægtede programmet at tegne en ethjulet cykel og erstattede den med en cykel. (Men hvis vi fjernede “Eifeltårnet” fra prompten, havde det ingen problemer med at producere det ønskede output).

Det er blot et par eksempler på DALL-E 2’s begrænsninger. De mere bekymrende udfordringer er komplicerede af natur og kan få alvorlige konsekvenser, både for virksomheden og dens brugere. Lad os tage et kig på dem.

Bekymringerne

OpenAI har programmeret DALL-E 2 til ikke at skabe billeder af offentlige personer og berømtheder. Faktisk nægter den direkte at generere billeder, der indeholder realistiske ansigter eller rigtige mennesker. Det er et skridt i den rigtige retning for at forhindre misbrug af programmet. Men i betragtning af den voksende tilgængelighed af deep fake-apps kan ondsindede aktører tage et DALL-E-billede og morphe en persons ansigt ind i det.

Krænkelse af ophavsretten kan også blive et stort problem, efterhånden som DALL-E 2 vokser i popularitet. OpenAI har hævdet , at brugerne “får fuld ret til at kommercialisere de billeder, de skaber med DALL-E, herunder retten til at genoptrykke, sælge og merchandise.” Men AI-kunstgeneratorer er afhængige af menneskelige kunstneres arbejde med at analysere, lære og skabe kunst. Så en potentiel overtrædelse af lovgivningen om intellektuel ejendomsret – uanset hvor utilsigtet den måtte være – kan ikke udelukkes.

Den endelige dom

Er DALL-E 2 perfekt? Som et værktøj i udvikling er svaret nej. Men som det er tilfældet med maskinlæring, bliver programmet gradvist smartere og mere kompetent med tiden. Fra et rent teknologisk synspunkt er DALL-E 2 et stort skridt fremme i udviklingen af AI-teknologi. Indtil for nylig var den almindelige opfattelse, at AI-systemer ikke realistisk set kunne udkonkurrere mennesker på kreative områder. I hvert fald ikke i den nærmeste fremtid. Men DALLE-2 har allerede gjort det argument stort set forældet. Og dermed har den også åbnet op for en dåse af orm.

Det skal retfærdigvis siges, at OpenAI har truffet en række foranstaltninger for at foregribe og forhindre potentielt misbrug af DALL-E 2. Det er ikke idiotsikkert, men visse kontroller og balancer er på plads. Hvor længe går der, før konkurrerende AI-systemer begynder at dukke op uden etiske grænser? Det er svært at sige, men vi vil helt sikkert holde nøje øje med denne spirende industri. For AI-kunstgeneratorer og teknologien bag dem vil kun blive mere udbredt i de kommende måneder og år.