Nvidias Rubin-chips gør kunstig intelligens til billig infrastruktur. Derfor begynder åbne intelligensmarkeder som Bittensor at få betydning.

Nvidia brugte CES 2026 til at signalere et markant skifte i, hvordan kunstig intelligens kommer til at køre. Virksomheden viste ikke forbrugernes GPU’er først. I stedet lancerede de Rubin – en rack-skala AI-computing platform, der er bygget til at gøre storskala inferens hurtigere, billigere og mere effektiv.

Rubin gør kunstig intelligens til industriel infrastruktur

Nvidias præsentation på CES gjorde det tydeligt, at de ikke længere sælger enkelte chips. De sælger AI-fabrikker.

Rubin er Nvidias næste generations datacenter-platform, der følger efter Blackwell. Den kombinerer nye GPU’er, højhastigheds HBM4-hukommelse, specialdesignede CPU’er og lynhurtige forbindelser i ét tæt integreret system.

I modsætning til tidligere generationer behandler Rubin hele racket som én samlet computer-enhed. Den opbygning mindsker databevægelse, forbedrer hukommelsesadgang og sænker omkostningerne ved drift af store modeller.

Det betyder, at cloud-udbydere og virksomheder kan køre AI med lange kontekster og tunge ræsonnementer til en langt lavere pris pr. token.

Det er vigtigt, fordi nutidens AI-opgaver ikke længere ligner en enkelt chatbot. De afhænger i stigende grad af mange mindre modeller, agenter og specialiserede tjenester, der kalder på hinanden i realtid.

Lavere omkostninger ændrer hvordan kunstig intelligens bliver bygget

Ved at gøre inferens billigere og lettere at skalere, gør Rubin det muligt at skabe en ny type AI-økonomi. Udviklere kan bruge tusindvis af fintunede modeller i stedet for én stor.

Virksomheder kan bruge agentbaserede systemer med flere modeller til forskellige opgaver.

Men det skaber et nyt problem. Når AI bliver modulært og let tilgængeligt, skal nogen beslutte, hvilken model der håndterer den enkelte forespørgsel. Nogen skal måle ydeevne, håndtere tillid og styre betalingerne.

Cloud-platforme kan hoste modellerne – men de leverer ikke neutrale markedspladser for dem.

Det hul er hvor Bittensor passer ind

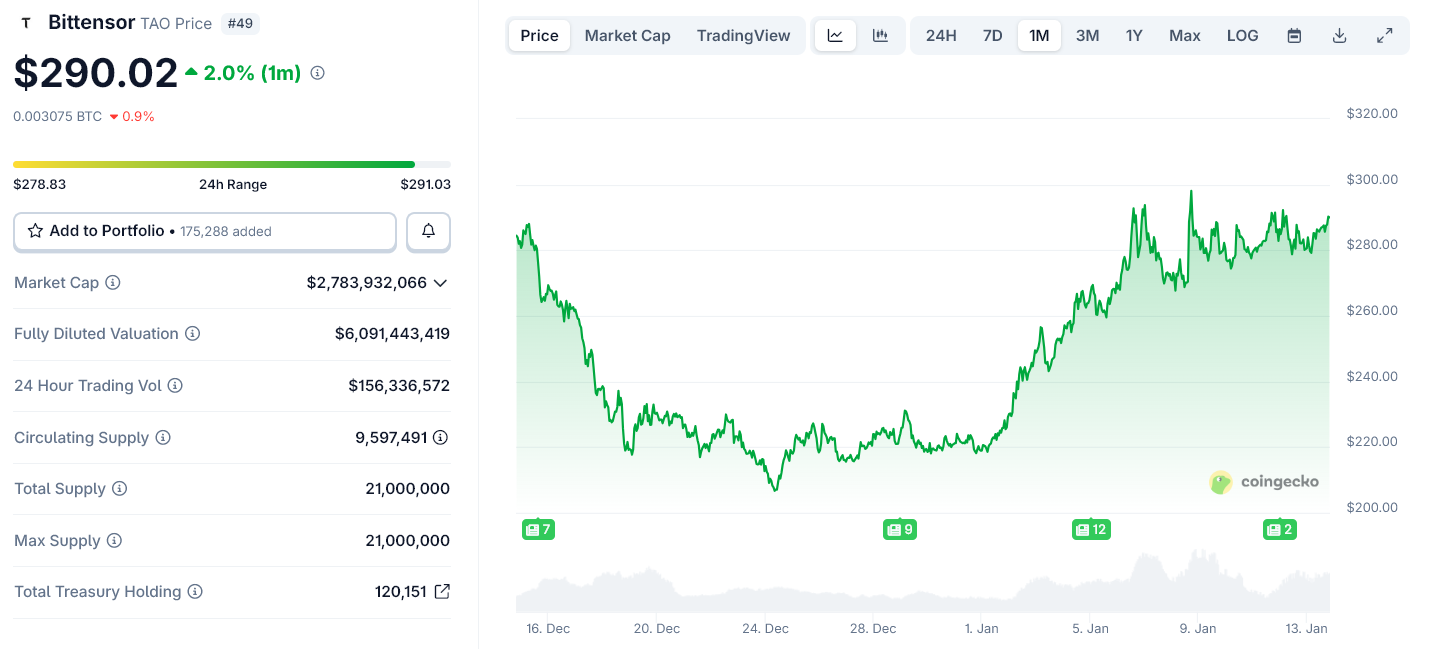

Bittensor sælger ikke regnekraft. Projektet driver et decentraliseret netværk, hvor AI-modeller konkurrerer om at levere nyttige resultater. Netværket rangerer modellerne med on-chain data om præstation og belønner dem med sin egen token, TAO.

Hver Bittensor subnet fungerer som et marked for en særlig type intelligens – f.eks. tekstgenerering, billedbehandling eller dataanalyse. Modeller som klarer sig godt, tjener mere. Dårligt præsterende modeller mister indflydelse.

Denne struktur bliver mere værdifuld, jo flere modeller der tilføjes.

Hvorfor Rubins fra Nvidia gør Bittensors model levedygtig

Rubin konkurrerer ikke med Bittensor. Rubin gør Bittensors økonomiske model mulig i stor skala.

Når Nvidia sænker omkostningerne til AI-drift, kan flere udviklere og firmaer lancere specialiserede modeller. Det øger behovet for et neutralt system, der kan rangere, udvælge og afregne modeller på tværs af clouds og organisationer.

Bittensor leverer netop dette koordineringslag. Det forvandler mængden af AI-tjenester til et åbent og konkurrencepræget marked.

Nvidia styrer det fysiske lag for AI – chips, hukommelse og netværk. Rubin styrker denne kontrol ved at billiggøre og fremskynde AI-drift.

Bittensor ligger ét lag over. Her håndteres AI-økonomien ved at bestemme, hvilke modeller der bliver brugt – og får betaling.

Efterhånden som AI bevæger sig mod agent-sværme og modulære systemer, bliver det økonomiske lag vanskeligere at centralisere.

Hvad det betyder fremadrettet

Rubins lancering senere i 2026 vil udvide AI-kapaciteten på datacentre og clouds. Det vil øge antallet af modeller og agenter, som konkurrerer om reelle opgaver.

Åbne netværk som Bittensor får gavn af denne udvikling. De erstatter ikke Nvidias infrastruktur – men giver den et marked.

På den måde svækker Rubin ikke decentraliseret AI. Det giver den noget at organisere omkring.